谷歌终于发布了期待已久的 Veo 3.1。

我在 X 上看到很多人说很失望,没有大的突破。我倒觉得还好,因为这本身就是一个小版本的迭代,又不是 4.0 发布。

所以我还是比较心平气和的去看待整体的改进。

其实 Veo 3.1 还是有不少面向用户真实使用场景的迭代,比如多图参考、首尾帧(是的,终于有了)。

我们测试了一天,感觉它的音频效果、画面的真实纹理都比上个版本有了很多提升。

Veo 3.1 还有另外一个我看到很少有人说的优点是:人物的一致性。同一个人,正面看,侧面看,甚至从背后看,人物都能保持高度一致。

不会出现之前那种换个角度人好像就不太一样的跳脱感。但中文的支持一如既往的差。

我看小红书上还有很多人在问怎么用 Veo 3.1,其实我之前给大家推荐过 Lovart,它会第一时间集成行业内头部的图片、视频模型。

昨天晚上睡觉的时候,谷歌还没有正式发布 Veo 3.1 ,但 Lovart 已经上线了。 没有任何的延迟。

我现在根本不会在这些地方浪费时间。新模型一出来,我就直接去 Lovart 打开看一眼,用起来熟门熟路,不需要再去注册新账号,熟悉新产品的界面。

好像花时间干这些事情,也没什么必要?

尤其是很多时候,我们需要用同一个提示词去对比不同模型的效果,这时候 Lovart 的优势就特别明显。

只要在画布里直接切换模型就行,不用来回跳界面。生成的视频也都会集中展示在同一块画布上,对比起来一目了然。

对了,即便没有付费,我们也可以在 Lovart 中免费试用几次 Veo 3.1。地址如下:

https://www.lovart.ai

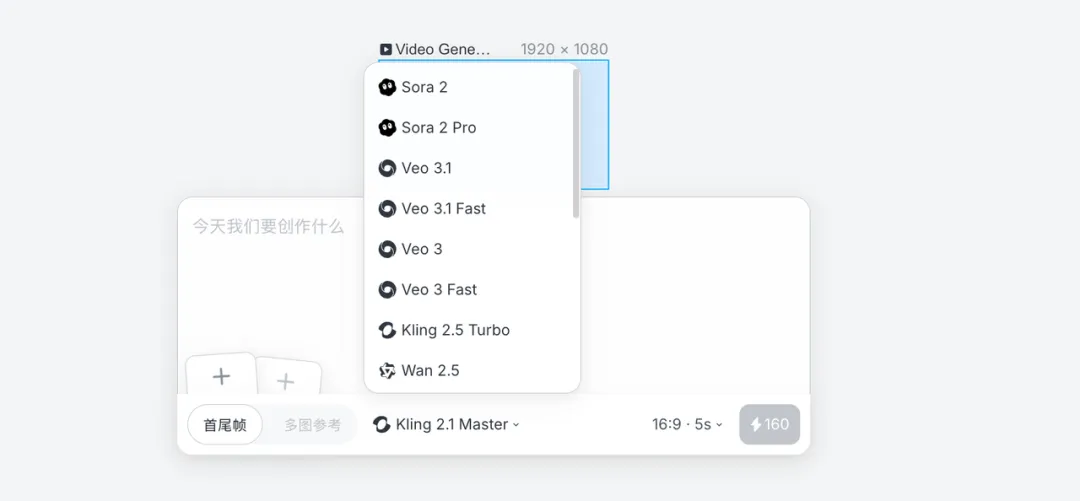

面这是具体画布的操作界面,我们可以选择 Sora 2、Veo3.1、Kling 2.5Turbo、Wan 2.5、Seedance Pro 等不同的视频模型。

为什么我喜欢用 Lovart?因为我的一个判断是,未来 AI 视频模型领域,将会存在多个不同的视频模型,并没有赢者通吃。

就像孩子的彩笔盒一样,每支彩笔都有自己的特点。

在 Lovart 中,选择模型就是在选择合适的彩笔,在画布上生成图片和视频的过程,就像小孩子拿着各式各样的彩笔在纸上涂涂画画一样。

举个例子,比如我们在做一个“梵高走进咖啡馆”的短片。这个场景里,他和不同的人交流、穿梭在灯光与画作之间。

Sora 2 的分镜最强,切换节奏自然,所以在需要多镜头衔接的片段,我们会用它。

Veo 3.1 支持多图参考,画面质感更逼真,就很适合放在人物特写中。

Kling 2.5 Turbo 的光影和走动最顺,适合表现人物在街头或室内的流动感。

这样搭配下来,我们整个视频的效果也会最佳。

我觉得没必要固执的非得用某一个模型。用它最擅长的部分就好。如果想清楚了这个逻辑,我觉得就不会过于在意到底是 Sora 2 牛,还是 Veo 3.1 牛。

这样,我们先来看一个 Veo 3.1 的生成效果。咱们用图生视频,我先是在 Lovart 中,用 Seedream 4 生成一张图片。

为了方便直观,我放下整体的 Gif 图。

我的操作逻辑是:先生成人物的图片,然后紧接着,再让人坐到马上面。

Gif 上你可以看到,我第一次生成人物的图片后,紧接着,又用提示词做了修改,心满意足之后,再把马加进来。

也许你会问,为什么不直接生成坐到马上的图片?

因为我的经验是,如果想制作连续的视频,最好还是先生成人物的主体照片,这样可以更好的保持一致性。

图片生成完后,我们就直接切换到视频模型,用 Veo 3.1 来生成视频。

这个过程几乎是无缝衔接的,从这里你就能感受到 Lovart 的方便。前脚还在用字节的模型出图,后脚就能用谷歌的模型生成视频。

整个过程不用切换界面、不用导出、上传文件,一气呵成。

.gif)

最后的效果如下。和其他几个模型一对比,Veo 3.1 的画面真实感确实更强。无论是光影的层次,还是人物表情的细微变化,都自然得多。

特别是音效,马蹄声随着步伐轻轻起伏,混着风声和尘土声,让整个场景更立体,也更有代入感。

但你也能看到,主人公说中文的音调特别违和。这也是我前面提到的,Veo 3.1 无论是提示词,还是声音,对中文的支持都不够好。

下面的视频,是我做完后用剪映拼接出来的效果,24 秒,全英文,你感受下。说真的,Veo 3.1 在细节上还是很能打。

Sora 2 模型的一个突出优势,是它可以在同一段视频中灵活地切换分镜。这个功能对做完整叙事类视频的创作者来说,太有用了。

以前大多数视频模型生成的都是一个连续的长镜头,如果想做出分镜效果,只能把每个片段单独生成,再去后期拼接,非常麻烦。

而 Sora 2 直接把这一步省掉了。它允许我们在提示词里,通过时间戳来指定每个镜头的内容。

比如 0 到 5 秒是远景,5 到 8 秒切中景,8 到 10 秒给特写。

模型会自动识别并生成对应的镜头变化,画面衔接自然,节奏感也更连贯。

我们看看 Veo 3.1 在这方面的能力如何。先放出来我的提示词,这个格式大家可以直接套用,方括号内是时间戳,下面是对应的提示词。

Big budget anime movie with clean lines and smooth movements

[00:00]

The woman earring a short hospital gown suddenly wakes up in her cryogenic chamber with cold breath

[00:02]

Cut to she walks away from the cyrochamber looking around the lab with control consoles on the left

[00:04]

Cut to backside of the woman walking down a hallway at the end of the hallway is a black ladder mounted to the wall that leads up a vertical pathway with some light emitting down from led lights on the walls

[00:06]

Cut to Below the woman as she ascends up the black ladder and above her is a manhole cover with four small holes in it that has light shining through them

[00:08]

cut to the woman climbing out of a manhole in the middle of an overgrown forest

[00:10]

Cut to the woman amazed looking around the beautiful forest with fireflies and deer running past

[00:12]

Cut to wide shot of the large beautiful forest with destroyed city with overgrown plants all around it in the far background

同样还是在 Lovart 中,我们分别使用同样的提示词和图片来生成视频。

操作非常简单,选中图片后,点击菜单栏中的生成视频按钮,然后选择模型,输入提示词,点击生成就行。

.gif)

是 Sora 2 的效果:

下面是 Veo 3.1 的效果:

同样,我还测试了可灵的最新模型。有一说一,在分镜这块,Sora 2 是最强的。

我们继续做个其他方面的对比,你就能理解为什么前面我说不同的模型像是不同的画笔,没有严格的名次之分。

提示词:

A young woman jogs steadily along a quiet park path in the early morning. Her feet hit the ground in a smooth rhythm, arms swing naturally, shoulders rotate with each stride. She glances down briefly at her watch, then lifts her head, noticing a small dog running past. She smiles slightly, head turning toward the dog, ponytail bouncing gently with her movements. Leaves rustle in the light breeze, sunlight filters through trees, casting soft dappled light on the path. Cinematic soft lighting, continuous natural motion, calm and peaceful storytelling atmosphere, wide park view

简单说下这个提示词的要点:

第一,年轻女子沿着公园小路慢跑。第二,她低头瞥了一眼手表,然后抬起头,发现一只小狗从她身边跑过。第三,树叶在微风中沙沙作响,阳光透过树木,在小路上投下柔和的斑驳的光。

我这个提示词已经相对复杂了。咱们看看 Sora 2 和 Veo 3 对提示词的理解能力谁更好一些。

同样,还是在 Lovart 中对比,我今天所有的操作都是 Lovart 哈。

实话,我现在都没有在 Gemini 或者谷歌的 AI Studio 中用过 Veo 3。Lovart 足够简单了。

下面是 Sora 生成的效果:

下面是 Veo 3.1 的生成效果:

Veo 3.1 在整体效果上几乎碾压 Sora 2。最明显的差距是音效,Sora 2 的环境音偏刺耳,风声和脚步声混在一起,听起来很假,缺乏空间感。

其次是画面细节。Sora 2 在人物动作上依然不太稳定,比如提示词里要求“年轻女子低头看手表”的镜头,它直接没生成出来,跑步的姿势也显得有些僵硬。

而 Veo 3.1 不仅能准确理解这个动作,还能生成细微的动态细节。低头、摆臂、头发的晃动都很自然。

整体对比下来,我觉得在这个场景中,Veo 3.1 的画面质感、光影表现和动作连贯性都明显更成熟。

另外,Veo 3.1 还有一个新的功能:多图参考。这个 Lovart 也已经支持。

比如,我想把下面三张图片,融合为一个视频,之前的话,还需要用 Nano Banana 拼接,现在,可以直接绕过这一步。

这是我在 Lovart 中的操作过程:

.gif)

下面是最终的成品,注意看摩托车和驾驶人在墙上的影子,这一点,绝了。心服口服啊。

我想说,虽然现在 AI 视频还有很多问题,但与两年前相比,已经取得了很大进步。

下面这个视频,你让我辨别是不是 AI 做的,我觉得我很难看出来。

多图参考这个功能,其实非常实用。

比如前面我生成的西部牛仔的照片,我想把它放到任意的场景中,无论是黄昏的公路、沙尘弥漫的荒野,还是灯光昏暗的酒馆。

这种情况下,我只要把人物照片和场景照图片传上去,再用提示词说明就可以生成视频了。它可以进一步降低视频创作的门槛。

如果你是我的老读者,可能还记得上周五我写过一篇文章,提到我们团队最近在尝试做一支完整的 AI 短片。

那不是一个随手玩的项目,而是一次从分镜、提示词、镜头语言到剪辑节奏的系统实验。

我知道团队能力还不足以以一个导演的视角生成一个高质量的短片,但我们就慢慢开始,积累能力。

这周,我的同事趁着空闲时间又继续干了几晚。

我们干脆又入手了 Lovart 的年度会员,一方面可以省去各种额度限制,另一方面也能第一时间免费体验到最新的视频模型。

现在 Veo 3.1 和 Sora 2 在 Lovart 里都是无限额度开放,生成速度也非常稳定。

下面是我们生成的短片(仍然还未完稿,还未精修)。它将会是我们通过 Lovart 创作的第一个完整作品。

这次我们用了不少模型:Nano Banana、Seedream、可灵、Veo 3.1、Veo 3、Sora 2……几乎涵盖了现在主流的视觉生成模型。在这个过程中,我们充分意识到:

每个模型都有自己的气质和强项,有的擅长渲染氛围,有的在动作细节上更自然,有的在光影和质感上更接近真实摄影。

我的思路依然是前面提到的:不追求一个模型包打天下,而是在不同场景中选择最合适的那一个。

就像电影导演在不同场景下,会挑不同镜头、光线和滤镜去表现情绪一样,我们在创作中,也会根据场景去选择最合适的模型。

有时候某个画面用 A 模型出不来效果,那我们就试试另外的模型。

Lovart 还是挺适合干这事的,我可以在一个画布上有序的按照剧本的构思逐步生成视频,省了太多工具和上下文之间的切换。

你看,这是我最近的一些零散项目。除了在做 AI 视频,我们团队现在也在筹备年底的 AI Maker Summit,像视觉主图、Logo、活动 KV 这些设计素材,其实也都是在 Lovart 里完成的。

我现在基本把 Lovart 当成一个统一的视觉工作台,无论是生成视频、设计视觉,还是出一张海报、Logo 草稿,都能在同一个环境里搞定。

它不仅集成了各家的视频模型,还支持 Midjourney 系列的图像模型,风格覆盖面很广,从写实到插画、从品牌风格到艺术概念都能 Hold 住。

昨天,我很喜欢的博主九边发了一个观点,他说建议每个人都应该尝试做做短视频。因为这是中国整个社会最大的流动窗口了。

我丈母娘是快手的用户,她经常看内蒙一个县的网红直播,听她说,那个县一个网红带另外一个网红,整个县的人们都富起来了。

九边的逻辑我还是很赞同。我现在回村里,也经常和身边表达力好的朋友这么讲。

但我也知道,短视频平台现在已经非常卷了,长腿美女饱和了,农村做饭题材的也饱和了。总之,想突围出来,没那么容易。

而 AI 视频还处在早期阶段,红利期非常明显,而且入门难度并不高。

短视频更多考验一个人的表达能力,而 AI 视频考验的,是镜头感和叙事力。你不一定要会拍、会演,但得知道画面怎么讲故事。

也正因为这样,我现在越来越觉得,AI 视频正像当年的短视频一样,正在酝酿下一波内容爆发。

推荐大家关注下这个方向,也同样推荐我超级喜欢的产品,Lovart:

https://www.lovart.ai

本文转载自公众号“AI产品阿颖”| https://mp.weixin.qq.com/s/s30Xnrs0s2SaT2dI0IU1JA|(编辑:潇飞)