2025 年 9 月 28 日,腾讯混元官方公众号宣布 混元图像 3.0 正式上线。这款模型不仅 开源且免费,更是业内首个 工业级原生多模态生图模型,参数规模高达 80B,性能直逼头部闭源大模型。

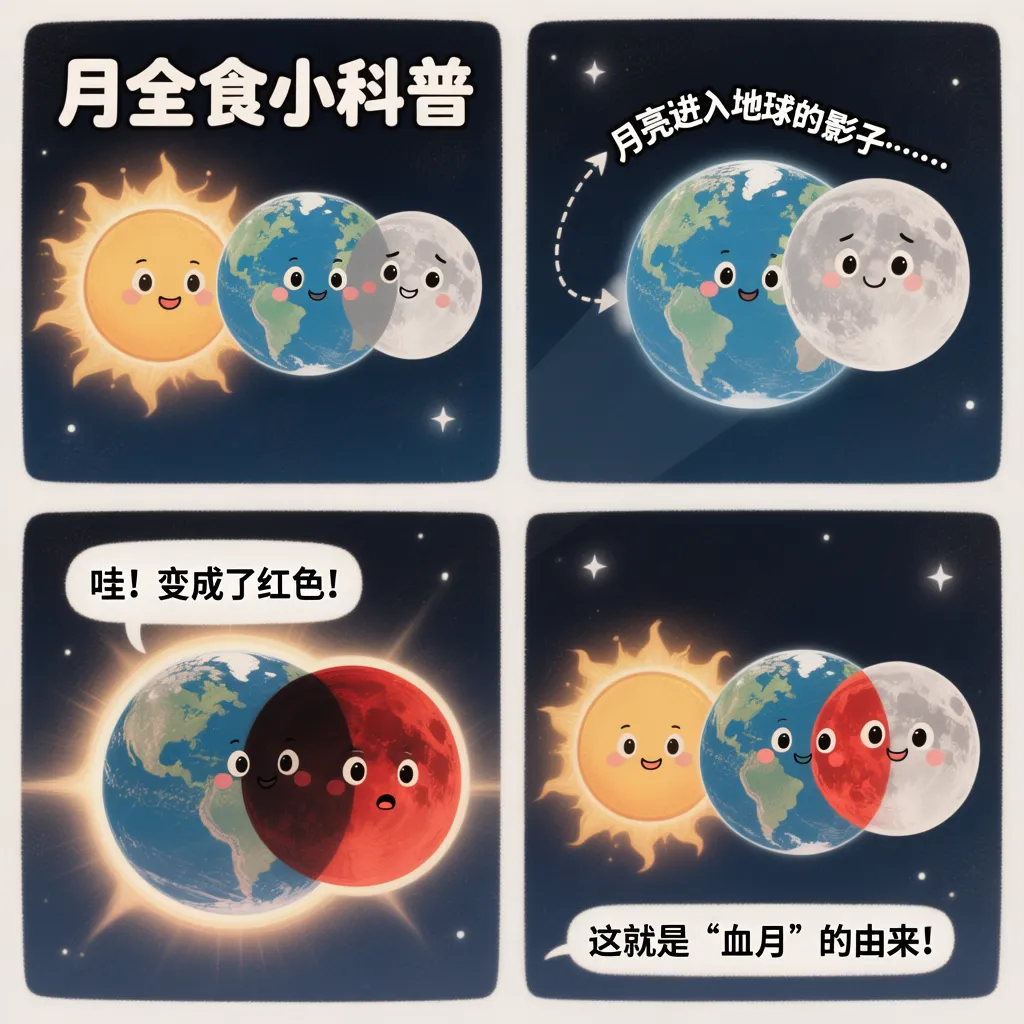

与市面上依赖多模型组合、参数规模偏小的开源方案不同,混元图像 3.0 实现了 文字、图像、视频、音频的原生统一处理。这种底层架构创新,让它能够像人类一样整合世界知识与语义逻辑。例如,用户输入“生成一幅月全食四格科普漫画”,模型会自动完成分镜、构图和科学细节补全,而无需逐帧提示。

在实际体验中,混元图像 3.0 能精准理解时尚语境、品牌调性和审美趋势:从“小红书风格穿搭封面”到“中秋创意海报”,它都能生成逼真的成品图像,细节如水珠、文字排版和色彩风格都符合专业水准。

其技术优势来源于 50 亿量级图文对、视频帧和 6T 语料训练,融合了多模态生成、理解与大语言模型(LLM)能力。目前开放的版本以文生图为主,未来还将扩展至图生图、图像编辑和多轮交互。

使用场景 覆盖插画师、设计师和内容创作者:过去需要数小时绘制的漫画,如今几分钟即可完成;没有美术功底的博主,也能轻松生成专业级封面。

最重要的是,腾讯将其 完全开源:模型权重和加速版本已在 GitHub、HuggingFace 发布,企业可基于此进行二次开发,学术界也能借助它探索多模态研究的前沿。

在行业层面,混元图像 3.0 意味着开源模型首次跨越从“学术实验品”到“工业级生产力”的鸿沟,直接树立了开源生态的新标杆。它延续了腾讯混元团队在图像生成领域的持续迭代——从原生 DiT,到 2K 高清、再到实时生成——此次则通过多模态能力,将视觉 AI 的应用场景推向更广阔的产业落地。

模型获取方式:

- 电脑端:访问 腾讯混元官网 → 开源模型 → 生图模型

- 微信端:搜索 “腾讯混元” 小程序

在业界专家看来,混元图像 3.0 的上线,预示着 2025 年的视觉创作方式或将迎来一场彻底变革。